语言,我觉得就是信息熵

最近在研究香农的信息论

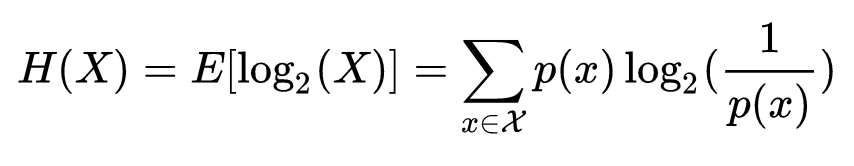

在信息论中,熵是接收的每条消息中包含的信息的平均量,又被称为信息熵、信源熵、平均自信息量。这里,“消息”代表来自分布或数据流中的事件、样本或特征。(熵最好理解为不确定性的量度而不是确定性的量度,因为越随机的信源的熵越大。)来自信源的另一个特征是样本的概率分布。这里的想法是,比较不可能发生的事情,当它发生了,会提供更多的信息。由于一些其他的原因,把信息(熵)定义为概率分布的对数的相反数是有道理的。事件的概率分布和每个事件的信息量构成了一个随机变量,这个随机变量的均值(即期望)就是这个分布产生的信息量的平均值(即熵)。熵的单位通常为比特,但也用Sh、nat、Hart计量,取决于定义用到对数的底。

采用概率分布的对数作为信息的量度的原因是其可加性。例如,投掷一次硬币提供了1 Sh的信息,而掷m次就为m位。更一般地,你需要用log2(n)位来表示一个可以取n个值的变量。

在1948年,克劳德·艾尔伍德·香农将热力学的熵,引入到信息论,因此它又被称为香农熵。

而诗意,我现在的理解就是:随机可能性达到一定高度的熵。

即:随机可能性越大的信息,越富有诗意。

数学,宇宙的语言

但是宇宙的语言都是数学吗?我真的不知道

@uqinzen “随机可能性越大的信息,越富有诗意”

我理解的是

在读者心里唤起的信息量越大的文字,越有诗意

这里的信息量包括联想 记忆 情绪/感知的联结 等等,比起单纯的说明性文本,信息量一定是几何级翻番的

@knockedhead 通常说的信息量是确定性的量(信息为了传播必然需要确定量化),如果要追求唤起的确定性的信息量,只需要增加投入的信息量即可,投入的信息量越大,唤起的信息量必然越大。

所以我认为是,可能性,也就是“不确定性的量”,这个跟投入量就没有必然关联了。

但是信息的确定性和不确定性可能就是一个事物的两面。

其中一个例子:黑箱子里有一个红球和一个白球。你伸手进去拿球的时候是不确定的,但你拿出来一看是红球。那么我伸手进去拿另一个球这件原本不确定的事儿马上就变成确定了

而恰恰这个确定性的部分使得信息的可以无止境的传播。而不确定性无法传播,只能靠诗意创造

uqn:宇宙本身就是一种语言编码的存在形式uqn:宇宙本身就是一种语言编码的存在形式https://mp.weixin.qq.com/s/_lYeEqS_h2Bpa7rzB9NzSw 17

@uqinzen 哦是的是的。。我表述错误,应该是可能性最大而不是信息量最大

我要把信息计量学翻出来复习下了。。

哦,信息论是用来分析和处理自然语言的,非常适合计算机